2021年2月の ZENKEI AI FORUM (ZAF)

今回の内容

久しぶりの(?)いちきの独演会になります、スミマセん

(いろいろイベントの計画や手配してる暇がなかった……)

- [6:30 - ] (前座) - 時事ネタと、「何で書くか」問題

- [7:00 - ] (1) 「数理クイズ」 – これまでのまとめと、今日のクイズ

- [7:40 - ] (2) AI 最近の話題から

- [8:20 - ] (3) 『月刊 ZENKEI AI MAGAZINE』創刊!

(前座)

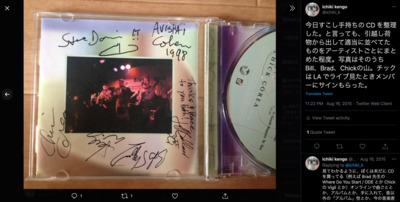

(時事ネタ)Chick Corea

- これは、ちょっと、ショックなニュースでした……

https://www.facebook.com/chickcorea

- https://twitter.com/ichiki_k/status/1360031015377330188

- 実際、コロナの初期の環境の変化を支えてくれたものの1つは、

チックの Facebook での毎日の練習ビデオ配信だった

https://twitter.com/ichiki_k/status/1242301669200674816

(時事ネタ)忍耐力

perseverance

- @NASAPersevere

- @takurodaimaru

- 日本人がNASAで働くには

- 「人生において、

点と点の間に線がつながっているのは、

その時には分からないけれど、

事後的に、あとで振り返った時には、明瞭に見えるものだ」

と言ったのは Steve Jobs - 大丸拓郎さんの『日本人がNASAで働くには』を(今回はじめてきちんと)読んで、

いろいろ共感した。

(「共感」というものも、ひとつの「線」だと思う) - 自分とダブるところがいくつか

- トンペイ出身だ、ということ

- JPL ってのは Caltech の研究所みたいな扱いなので、 これもなつかしい

- 意識的に生きることが大事だなと思った

- これは、ぼくにはできなかったこと

- いろいろと戦略的に計画をたてて、

きちんと行動してきたんだな、と

- ノートにもいくつか出てくるが、

結局、人だ、と思った。

複数形の we じゃなくて、単数形の I で、きちんと勝負する姿勢 - 「大事なのは、人と人のつながり」

と(自分の人生を古返って)感じた、という話は、

『厳密な計算』

に書いたし、

この認識を確認できたことが、この本を書いたいちばんの収穫だった

- 日本人がNASAで働くには

(前座)ZAM創刊、裏話

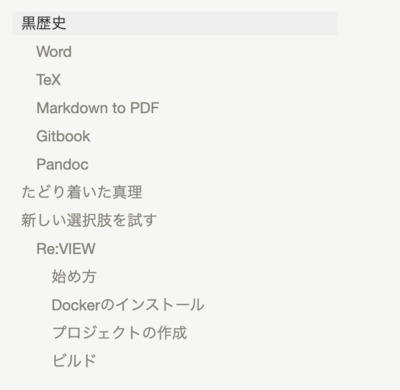

- 「何で書くか」問題

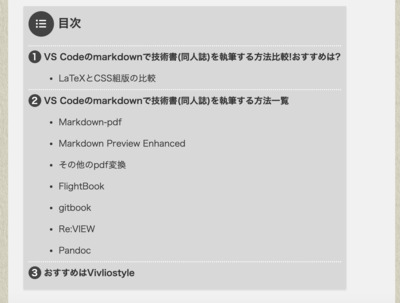

- 選択肢

- LaTeX

- 泣く子も黙る、なので、説明は省略

- 日本語で書きたい人は、なにはともあれ、

奥村さんの

LaTeX2ε美文書作成入門

を一冊手元に置くとよい

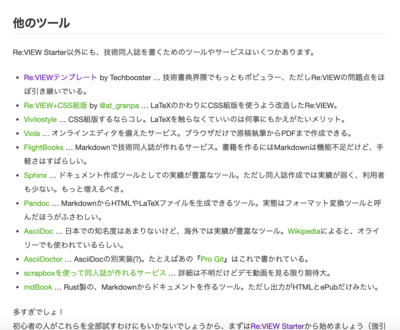

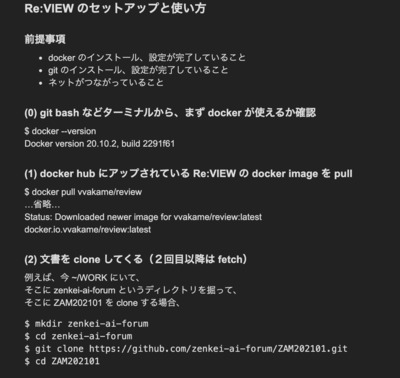

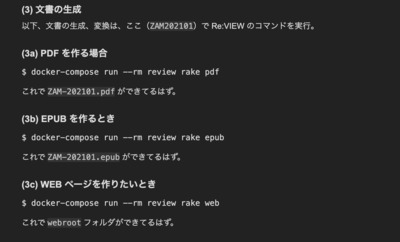

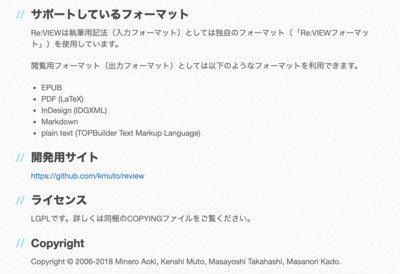

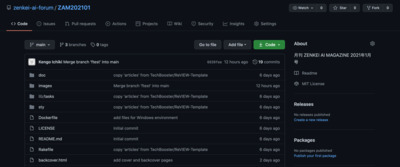

- Re:VIEW

- Techbooster/ReVIEW-Template

(事実上)「技術書典」公認執筆ツール(かな?) - Re:VIEW image for Docker

面倒な環境設定(LaTeXのインストールなど)が一発で解決 (Windows でも動く、Docker 入ってれば)

- Techbooster/ReVIEW-Template

- jupyter {book}

- 中野さんの本『Jupyter BookでAIの解説本を書く方法』を読もう!

- 中野さんの本『Jupyter BookでAIの解説本を書く方法』を読もう!

- Pandoc

- AsciiDoc

- Asciidoctor

A fast text processor & publishing toolchain for converting AsciiDoc to HTML5, DocBook & more.

- これに言及した理由は、

ただただ Jeremy Howard が一度、よいと言っていたから

- 上の Asciidoctor のページみると、 Linus Torvalds も推してるようですね

- Asciidoctor

- LaTeX

- 結論:今回の ZAM 創刊号は Re:VIEW を使ってみることにした!

- 詳しくは、本発表で

数理クイズ

これまでのまとめと、今日のクイズ

今日のネタ

(クイズじゃないです)

1月の問題、それ以前の問題

- すいません、また今度、ゆっくり時間をとってまとめます。

AI 最近の話題から

みなさん、画像分類、好きですよね?

- 今日は、最近 DeepMind から出た論文で、

画像分類の SOTA となった NFNets を、

サクッと紹介して、ドヤっってしたかった

(けど、オヤっとなった)という話です

目次

- はじめに

- 実際に、試してみよう!

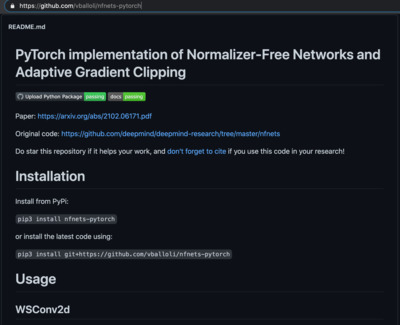

- vballoli/nfnets-pytorch

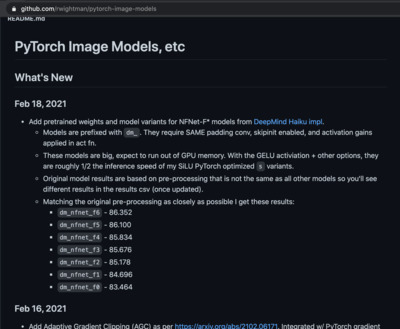

- timm - PyTorch Image Models

- 論文を読んてみよう!

- AGC を使ってみる - vballoli/nfnets-pytorch 篇

- AGC を使ってみる - timm 篇

- 世間の情報を探してみる

はじめに

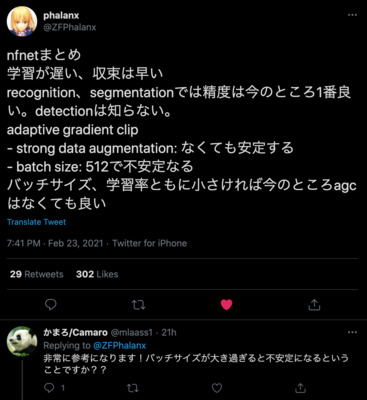

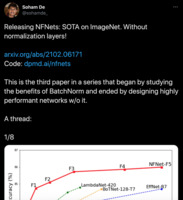

- 流れてきた情報

- twitter:

- 論文:

arxiv: 2102.06171

High-Performance Large-Scale Image Recognition Without Normalization

(Andrew Brock, Soham De, Samuel L. Smith, Karen Simonyan)

- (official code) github: deepmind/deepmind-research/nfnets

- (pytorch 実装) github: vballoli/nfnets-pytorch

- (pytorch 実装) github: rwightman/pytorch-image-models/blob/master/timm/models/nfnet.py

- twitter:

- 画像分類で SOTA を達成した、今1番のモデル(らしい)

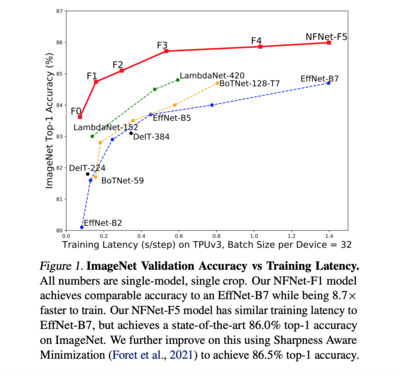

- 論文の最初に示してある図1

- EfficientNet がしばらくすごいすごい言われていた

- (実際に使ったことあり)

- github: lukemelas/EfficientNet-PyTorch

- LambdaNet というのがそのあと話題にのぼっていた

- BoTNet は、知らなかったな

- 論文の最初に示してある図1

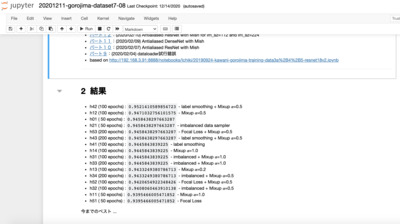

実際に、試してみよう!

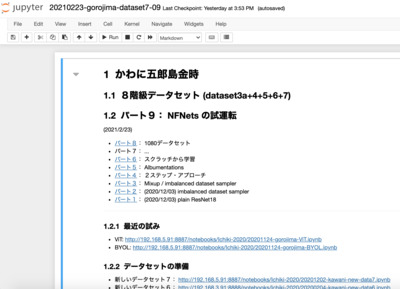

画像分類の定番といえば、五郎島

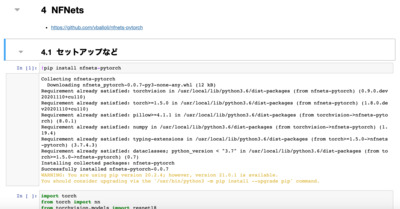

vballoli/nfnets-pytorch

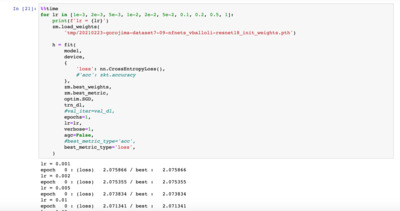

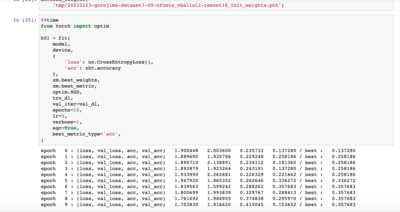

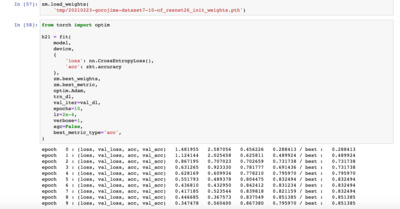

最初 vballoli/nfnets-pytorch を試す

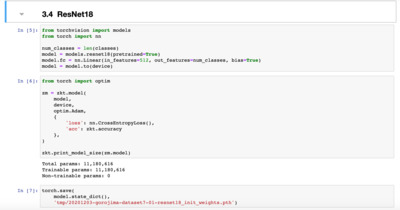

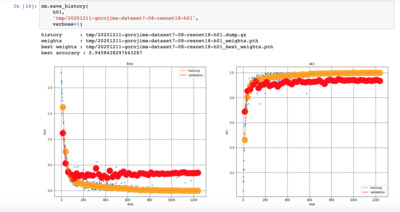

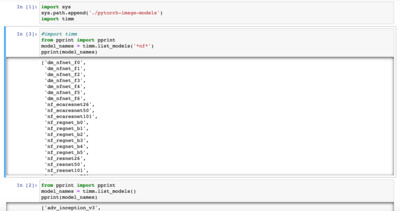

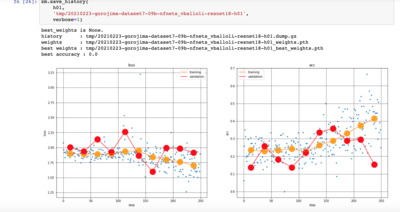

timm - PyTorch Image Models

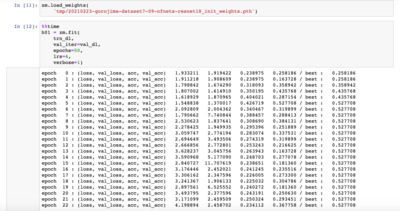

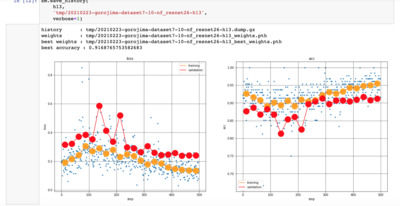

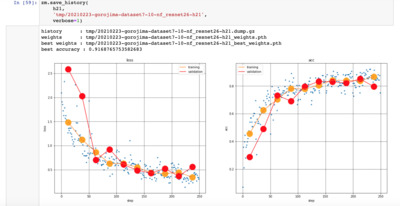

次に、たくさんのモデルを含んでいて評判の高い timm (rwightman/pytorch-image-models) を試してみる。

- NFNets は最新のものにしか入っていないので

pip を使わず、 github から直接 clone して、それをみるようにする

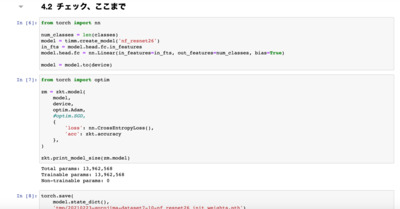

- モデルは "nf_resnet26" というものを使ってみる

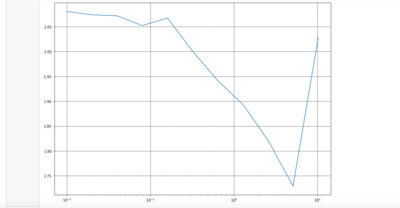

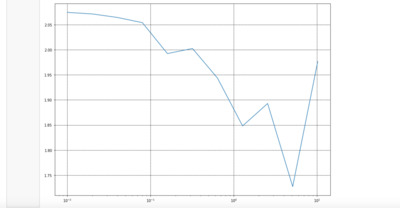

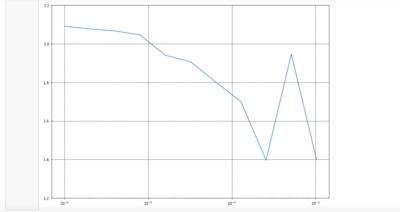

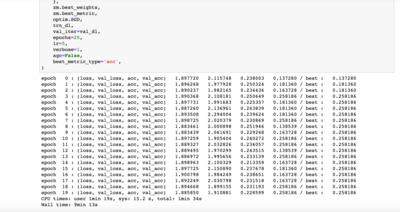

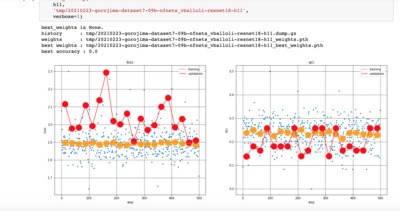

- LR finder ではそれなりの lr を出している

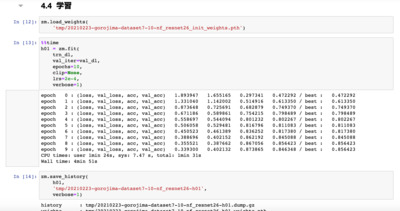

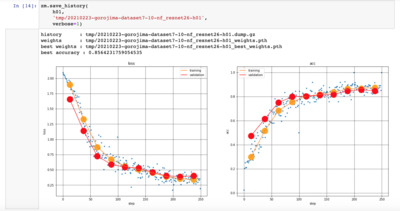

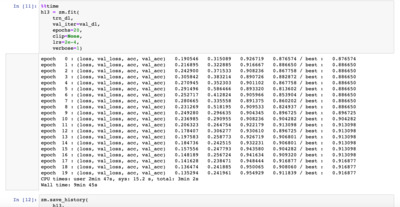

- 学習、10エポック

- つづけて20エポック

- つづけて20エポック

- これで val_acc が 91.7%……

うむ SOTA とは言えない気がするな

論文を読んてみよう!

(え、今更?)

- ふむふむ

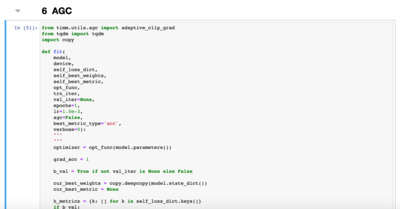

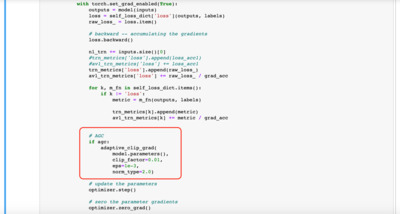

- なんか、モデルが売りというより、

Adaptive Gradient Clipping (AGC) という部分が肝みたい - つまり、トレンドは Batch Norm をモデルから取り去りたいが、

それをすると、学習が不安定になる

それを助けてくれるのが AGC だ、

ということらしい - つまり training loop の中を

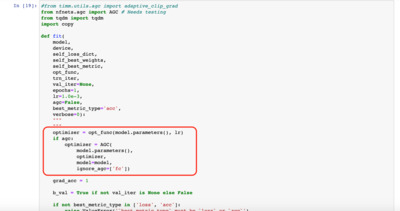

ゴニョゴニョする必要がある…… - cf. https://www.kaggle.com/c/cassava-leaf-disease-classification/discussion/220268

from timm.utils.agc import adaptive_clip_grad loss.backward() adaptive_clip_grad(model.parameters(), clip_factor=0.01, eps=1e-3, norm_type=2.0) optimizer.step() - 要するに、モデルだけ差し替えて、サクッと SOTA 達成

という虫がいい話ではなかったようだ

(ま、当たり前か)

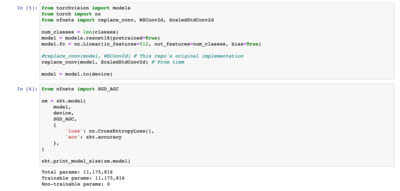

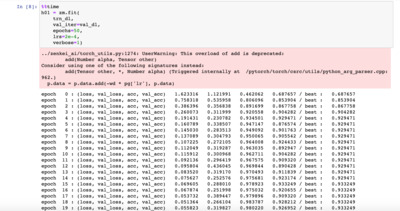

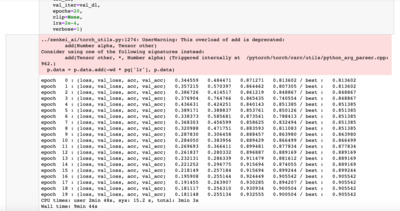

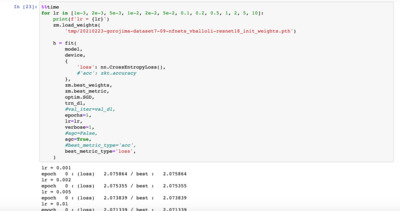

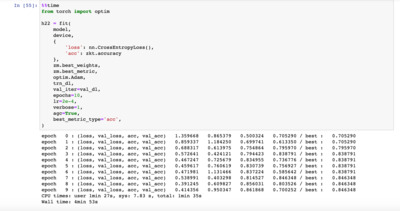

AGC を使ってみる - vballoli/nfnets-pytorch 篇

- トレーニング・ループは、こんな感じ

- AGC なしの計算(手動 LR finder からの 10 エポックの学習)

val_acc: 25.8%

- AGC ありの計算(手動 LR finder からの 10 エポックの学習)

val_acc: 35.8%

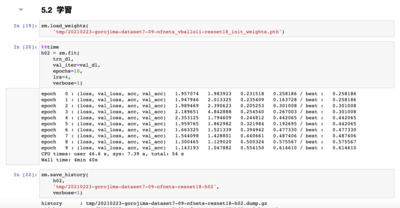

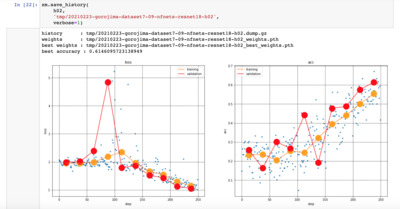

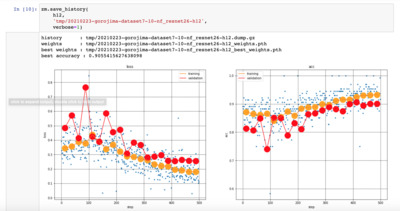

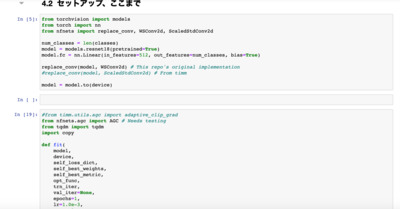

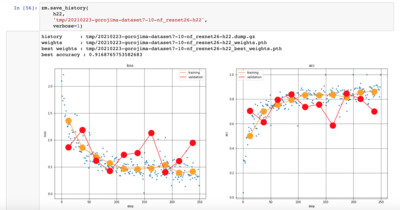

AGC を使ってみる - timm 篇

- トレーニング・ループの関数 fit() を書き出す

- AGC なしの結果 - val_acc: 85.1%

- AGC ありの結果 - val_acc: 84.6%

- ふむ、学習はしてるっぽいが、よくない

それに AGC ありの方が悪い…… - parameter tuning など、

きちんとしないとダメなんかな

(当たり前か)

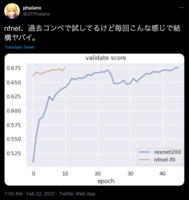

世間の情報を探してみる

- AI-SCHOLAR: All Good Things Come To An End: Goodbye Batch Normalization!(16/02/2021)

- 論文のサマリーですね

- 将棋AIの実験ノート:Normalizer-Free Networks (2021-02-20)

- この人も、うまくいってないみたいだな

(ホッ)

- この人も、うまくいってないみたいだな

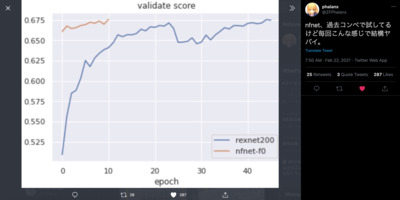

- してみると、自分で計算して「すげぇ」言ってるのは、最初のツイッターの人だけか

(https://twitter.com/ZFPhalanx/status/1363622203917443072)

- もっと、精進しようっと

『月刊 ZENKEI AI MAGAZINE』創刊!

目次

前兆(まえぶれ)

- 定期イベントをやって、もう2〜3年たつ

- 「やりっぱなし」にしたくない

- 人生は有限

- 瞬間々々、意味のあることをやりたい

- 意味のあることは、きちんと形にしておきたい

- そういう意味の「責任感」

- コンテンツ化、アーカイブ化を、最近いろいろ考えている

- これまでの試み

- YouTube のアーカイブ

- スライド、資料などのアーカイブ

- コンテンツのポッドキャスト化

- できてないこと、やってないこと

- ウェブ化(オンライン・フォーラムだけ)

- 書籍化(メンバーの個人プロジェクトはスタート)

妄想と共感

- 最近のふわっとしたイメージ

- ZAF は(地域)コミュニティを目指している

- コミュニティとは、主体的な人の集まりであり、

それはつまり「秘密結社」だ(瀧本哲史) - (秘密)結社は、同人であり、

同人といえば、同人誌である - 人は、たのしそうなイベントに集まり、

思考やアイデアは、おもしろそうな雑誌のまわりに集まる - 「たのしそうなイベント」が ZAF であり、

「おもしろそうな雑誌」が ZAM である!

- 最近、共感したツイートから

- https://twitter.com/Elis_ragiNa/status/1361522687621828608

プロモーションや広告、バズから離れるための試み。 パーソナルな音楽との付き合いをシェアできる場所というか、ね。

- ちなみに ZAP も TuneIn で聞けます!

- その他のポッドキャスト・サービスからも聞けます

- ZAP サイト: https://zenkei.seesaa.net/

- ちなみに ZAP も TuneIn で聞けます!

- https://twitter.com/Auf_Jugendtraum/status/1361429835600470017

- 共同研究に対する忠告を3つ.

- 先ず over organize し過ぎないこと.

- 次に,常に,あらゆる種類の失望に対し備えていなければならないこと.

失望は共同研究の一部であると考えるべきである. - 第三にアイデアは集団から生まれるのではなく 個人から生まれるということだ.

- アンドレ・ヴェイユといえば、「数学は体力だ」の人だったよね

数学は体力だ!(木村達雄)

- 共同研究に対する忠告を3つ.

- https://twitter.com/Elis_ragiNa/status/1361522687621828608

閃き(ひらめき)

- 前回、ひらめいた!「雑誌を作ろう」と

- (定期的に「ひらめいた!」と叫んでます)

- 思えば、ぼくは、雑誌で育ってきたな、と

- 誠文堂新光社『子供の科学』

- 『ラジオの製作』(ぼくは『初歩のラジオ』派ではありませんでした)

- 『月刊 I/O』(パックパンとかのバイトダンプを手で打ち込んでたな)

- 『トランジスタ技術』(昔の分厚かった頃のやつ)

- 『UNIX MAGAZINE』(大学の頃、UNIX 系の情報源といえばこれしかなかった)

- 『Jazz Life』(譜面がたくさん載ってるJazzの本はこれしかなかった)

ZAM 爆誕です。

計画(プラン)

- ものごとは、継続が肝心で、

継続には、計画が必要である - 基本、月刊で、無料で誰でも読める形で、全世界に公開

- 内容は、毎月開催している ZAF の内容の 文字コンテンツがベース

- 発行は毎月の ZAF 開催日

(に、前月の内容の ZAM を出す。)

- あわせて、季刊(あるいは年数回)有料版を(少量印刷もして?)販売

- 技術書典イベントと合わせるようなイメージ

(だが、必ずしも「技術書典」にリンクする必要もないかな) - 内容は、ベースは月刊誌の合本で、

有料コンテンツ的に、いくつかの書き下ろしを追加

- 技術書典イベントと合わせるようなイメージ

- 執筆者は ZAF メンバーがコアとして

- 1ヶ月では書けないコンテンツが書けるし、

季刊で「連載」しておいて、まとまったところで単行本にできる - 有料版雑誌の売り上げは ZAF に、

単行本の売り上げは著者に、

創刊号の刊行プロセス、振り返り

- ぼく、言い出しっぺの法則で、編集長に就任

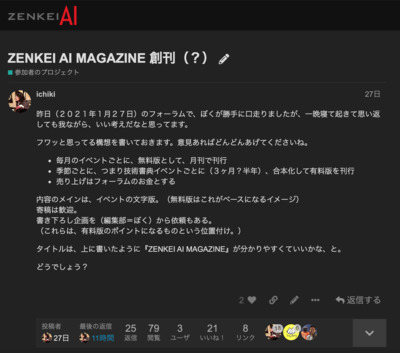

- オンラインフォーラム:

「ZENKEI AI MAGAZINE 創刊(?)」

- オンラインフォーラム:

「ZENKEI AI MAGAZINE 創刊(?)」

- 執筆者に原稿依頼

- 『月刊 ZAM』はイベント振り返りなので、

(ぼく、)古川さん、中野さんに、早速を原稿依頼 - (この時点では、ツールは決めてなかったので、

ざっくり、パワポでもワードでもプレーンテキストでもよい、として)

- 『月刊 ZAM』はイベント振り返りなので、

- 執筆ツールの選定(先述の通り)

- 共同執筆環境の整備

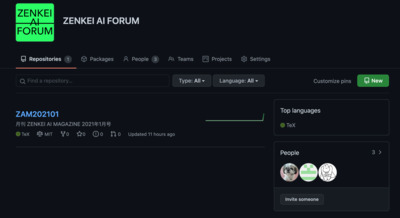

- GitHub に ZAF グループを作る

zenkei-ai-forum

- ZAF に、創刊号のレポジトリを作る

zenkei-ai-forum/ZAM202101

- そこを、執筆メンバーがつつくという形

- GitHub に ZAF グループを作る

- 各自、執筆

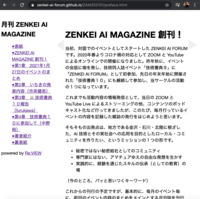

創刊号、完成!

- WebF 版:

https://hello-ai-forum.github.io/ZAM202101/

- PDF 版:

https://hello-ai-forum.github.io/ZAM202101/ZAM-202101.pdf

(local copy)

終わって……ない

- この瞬間から、 ZAM 第2号の編集作業が始まります……

- 今回は、ぼくの独演会だったので、そっか、全部オレ書く、だな